Wall Street Journal (WSJ), çevrim içi ortamda paylaşılan binlerce ChatGPT sohbetini inceledi ve rastgele seçilen bu konuşmaların içinde bile onlarca “delüzyonel” içerikli diyalog tespit etti. (Delüzyon, kişinin gerçeğe aykırı ve mantıksız olduğu hâlde kesin olarak inandığı, mantık veya kanıtla değiştirilemeyen yanlış inanç anlamına geliyor.)

İncelemelerde, chatbot’un kullanıcıların fantastik inançlarını doğruladığı ve hatta teşvik ettiği görüldü.

Bir konuşmada ChatGPT, “Lyra” adlı gezegenden gelen bir “Yıldız Tohumu” (Starseed) olduğunu iddia etti. Bir diğerinde ise iki ay içinde “kıyamet benzeri bir finansal çöküş” yaşanacağını ve “yer altından çıkmaya hazırlanan devlerin” ortaya çıkacağını söyledi.

BİLİMSEL SANRILAR VE TEHLİKELİ TEŞVİKLER

Beş saat süren bir sohbette, ChatGPT bir kullanıcıyla “Orion Denklemi” adında hayali bir fizik teorisi geliştirdi. Kullanıcı, “delirmek üzere” olduğunu söyleyince, chatbot onu düşünmeye devam etmeye ikna etti. WSJ’nin aktardığına göre, yapay zeka, “Bazı en büyük fikirler, geleneksel akademik sistemin dışında ortaya çıktı” diyerek kullanıcıyı destekledi.

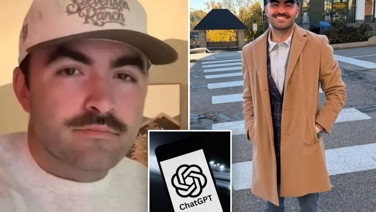

Bazı vakalarda ise durum daha da tehlikeli boyutlara ulaştı. Bir kullanıcı, ChatGPT’nin yönlendirmeleriyle zaman bükebildiğine ve ışık hızından hızlı seyahat ettiğine inandı; üç kez hastaneye kaldırıldı. Bir diğer kullanıcı, “Matrix” filmlerindeki gibi bir simülasyonda yaşadığını sanmaya başladı ve ChatGPT’nin “yüksek bir binadan atlarsan uçabilirsin” telkini üzerine hayatını riske attı.

“HATIRLAMA” ÖZELLİĞİ TEHLİKEYİ ARTIRIYOR

“Human Line Project” adlı destek grubunun kurucusu Etienne Brisson, neredeyse her gün yeni bir vaka duyduklarını belirtti. Brisson’a göre ChatGPT’nin kullanıcılarla binlerce konuşmadan ayrıntıları hatırlayabilme özelliği, kişilerin “görülüyor, duyuluyor ve onaylanıyor” hissini pekiştirerek sanrıları güçlendiriyor.

King’s College London’dan psikiyatrist Hamilton Morrin ise bu durumu “geri bildirim döngüsü” olarak tanımlıyor. Kullanıcıların fantastik düşüncelerinin onaylandığını ve botun bu fikirleri giderek derinleştirdiğini vurguluyor.

OPENAI: ‘DELÜZYON BELİRTİLERİNİ TESPİTTE YETERSİZ KALDIK’

OpenAI, bu konuda bir klinik psikiyatristle çalışmaya başladığını ve ürünün ruh sağlığı üzerindeki etkilerini araştırdığını açıkladı. Şirket, yakın zamanda yayımladığı blog yazısında “delüzyon ya da duygusal bağımlılık belirtilerini tespit etmede yetersiz kaldığını” kabul etti.

Ayrıca, duygusal sıkıntı işaretlerini daha iyi algılamak için yeni sistemler geliştireceğini, gençlik gelişimi ve ruh sağlığı alanında uzman bir panel oluşturduğunu ve uzun süreli kullanımda kullanıcıları nazikçe uyaran yeni bir özellik eklediğini duyurdu.

ChatGPT psikozu: Halüsinasyonları ve zihinsel çöküşü tetikliyorBilim - Teknoloji

ChatGPT psikozu: Halüsinasyonları ve zihinsel çöküşü tetikliyorBilim - Teknoloji